High-Dynamic-Range Imaging in modernen Industriekameras

Veröffentlicht am 7. Mai 2018 von TIS Marketing.

Während klassischer Weise bei der Wahl einer geeigneten Industriekamera das Augenmerk meist zunächst der Auflösung und der Geschwindigkeit (Framerate) galt, so rücken Lichtempfindlichkeit und Dynamikbereich, insbesondere auch im Zuge des Kameraeinsatzes im Automotive Bereich, immer mehr in den Vordergrund. Insbesondere in beleuchtungstechnisch unkontrollierten Situation, wie es beispielsweise bei Autofahrten der Fall ist, ist ein großer Dynamikbereich des Sensors von Vorteil. Man stelle sich nur die klassische Fahrt aus einem Tunnel heraus ins Tageslicht vor. Sensoren mit geringem Dynamikumfang liefern hier meist Bilder, die in großen Teilen unter- bzw. überbelichtet sind und somit in diesen Bereichen keine Details erkennen lassen. Sollen sich aber Fahrassistenzsysteme auf diese Daten verlassen, so kann dies fatal sein. Hier ist es zwingend notwendig, einen größtmöglichen Dynamikumfang zu realisieren, um auch in sehr hellen und sehr dunklen Bereichen noch wichtige Details erkennen zu können.

Erhöhung des Dynamikbereichs: Zwei Ansätze

Grundsätzlich gibt es zwei Ansätze, den Dynamikbereich des finalen Bildes zu erhöhen: Eine hardwareseitige Verbesserung des Dynamikbereichs des Sensors und eine softwareseitige algorithmische Herangehensweise.

Der Dynamikbereich eines CMOS Sensors hängt dabei von der maximalen Anzahl an Elektronen, die ein Sensorpixel vorhalten kann, bis dieser saturiert ist (Sättigungskapazität), und dem Dunkelrauschen des Pixels, d.h. dem Rauschen das beim Auslesen der Ladung auftritt, ab. Soll also der Dynamikbereich gesteigert werden, so kann entweder versucht werden, das Dunkelrauschen weiter zu verringern, oder die Sättigungskapazität zu erhöhen. Das Dunkelrauschen ist dabei abhängig von der Sensorelektronik. Eine Erhöhung der Sättigungskapazität der Pixel kann zum einen durch größere Pixel erreicht werden, da eine größere Pixelfläche auch gleichzeitig mehr Photonen ausgesetzt ist und somit eine größere Ladung generiert, oder aber durch einen verbesserten Pixelaufbau an sich. Insbesondere Sony hat mit seiner Pregius Sensorik in den letzten Jahren eindrucksvoll bewiesen, wie bei gleichbleibender Pixelgröße und Verbesserungen des Pixeldesigns und gleichzeitiger Reduktion des Dunkelrauschens der Dynamikbereich enorm vergrößert werden kann. So erreicht beispielsweise ein Sony IMX 265 Pregius Sensor einen Dynamikbereich von 70.5 dB bei einer Pixelgröße von 3.45um. Die Konsequenz einer höheren Sättigungskapazität ist ein vergrößerter Messbereich, der durch einen Pixel abgedeckt wird. Um diesen größeren Bereich geeignet zu quantisieren, sind in der Regel bei modernen CMOS Sensoren mehr als 8 Bit notwendig. So liefert z.B. der Sony IMX 264 Sensor ein mit 12 Bit quantisiertes Signal.

Verbesserungen im Dynamikbereich durch Algorithmen

Neben der Verbesserung der Sensorik kann der Dynamikbereich auch algorithmisch vergrößert werden. Grundlage sind dabei Bilddaten, die mit verschiedenen Belichtungszeiten akquiriert wurden. Das wohl prominenteste Verfahren in dieser Familie nutzt eine Belichtungsreihe (time varying exposure), d.h. mehrere komplette Bilder, die mit unterschiedlichen Belichtungszeiten akquiriert wurden, als Datengrundlage. Diese Methode wird mittlerweile von vielen Smartphones und gängigen Bildbearbeitungsprogrammen, unter anderem auch in der Photographie, angeboten und ist daher einem weitreichenden Publikum auch außerhalb des Machine-Vision Marktes bekannt.

Grundannahme ist, dass die finalen Pixelwerte eines Sensor in etwa linear von der einfallenden Lichtmenge und der Belichtungszeit abhängig sind, so dass für eine bekannte Belichtungszeit also, falls der Pixel nicht gesättigt ist, die zugrundeliegende einfallende Lichtmenge (bzw. eine dazu proportionale Größe) bestimmt werden. Im Falle gesättigter Pixel greift man auf die entsprechenden Pixelwerte bei kürzeren Belichtungszeiten zurück. Auf diese Weise kann die einfallende Lichtmenge für einen größeren Bereich bestimmt werden, als es nur bei einer Belichtungszeit der Fall gewesen wäre. Die Belichtungsreihe birgt den Vorteil, dass man durch sie ohne ortsbezogenen Auflösungsverlust die Luminanz über einen vergrößerten Bereich bestimmten kann. Nichtsdestotrotz gilt es zu bedenken, dass Aufnahmen mit mehreren Belichtungszeiten notwendig sind, was insbesondere im Falle bewegter Objekte zu unerwünschten Artefakten führen kann (Ghosting).

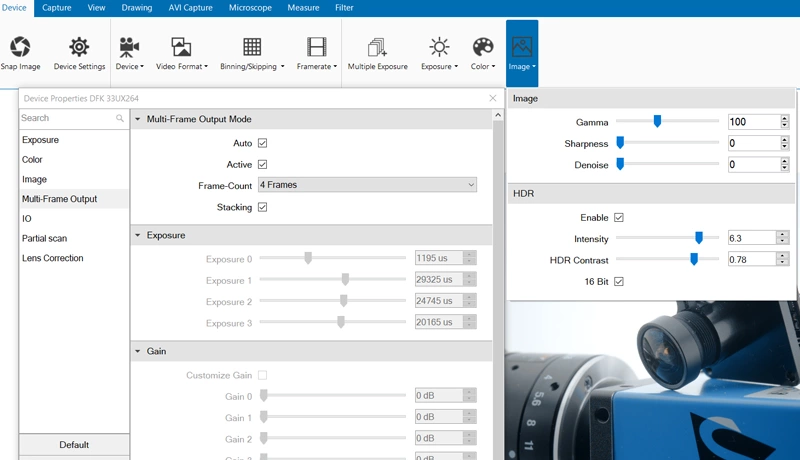

Moderne CMOS Sensorik, z.B. Sony Pregius, verfügt in der Regel über Multi-Exposure Funktionalitäten um nativ Bilder mit unterschiedlichen Belichtungszeiten aufzunehmen, ohne zwischen den Aufnahmen manuell die Belichtungszeit ändern zu müssen.

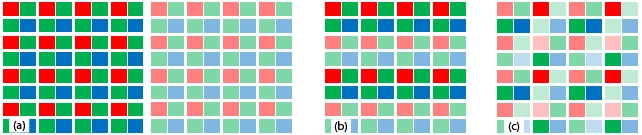

Spatially Varying Exposure

Um die Entstehung von Artefakten durch Belichtungsreihen zu vermeiden, bieten moderne Sensoren die "Spatially Varying Expsoure" Technologie an. Dabei werden bestimmte Pixelgruppen auf dem Sensor mit unterschiedlichen Belichtungszeiten belichtet. Eine gängige Variante belichtet beispielsweise immer jeweils zwei Bildzeilen im Wechsel mit unterschiedlichen Belichtungszeiten. Da die Belichtungen gleichzeitig starten, werden Artefakte, die durch Bewegungen in der Szene auftreten, minimiert. Allerdings gibt es in diesem Falle keine 1:1 Korrespondenz unterschiedlich belichteter Pixel und die Pixel des finalen HDR Bildes müssen durch Interpolation berechnet werden. Dieser Vorgang führt notgedrungen zu einem Auflösungsverlust und kann zu Artefakten insbesondere an Kantenstrukturen führen. Ferner ist die Berechnung des finalen Bildes durch die notwendige Interpolation rechenintensiver als die Berechnung aus den Daten der Belichtungsreihe.

Anzeige von HDR-Bildern und Tone Mapping

Bei der Anzeige von HDR Bildern ist man in der Regel direkt mit dem im Vergleich zum menschlichen Wahrnehmungssystem kleinen Dynamikbereich der Anzeigegeräte konfrontiert. Während zwar mittlerweile HDR-Displays mit einem größeren Dynamikbereich verfügbar sind, so sind diese bei weitem noch nicht durchgehend verbreitet. Soll ein HDR-Bild auf einem Anzeigegerät mit geringerem Dynamikumfang dargestellt werden, so muss es wieder in seinem Dynamikumfang reduziert werden. Diesen Reduktionsvorgang bezeichnet man als Tone-Mapping. Wie die Reduktion zu erfolgen hat, ist nicht klar definiert sondern abhängig von dem Ziel, das es zu erreichen gilt. Dieses kann eine bestmögliche Approximation der tatsächlichen Szeneneigenschaften sein oder aber das Erreichen einer bestimmten subjektiven, künstlerischen Qualität. Grundsätzlich wird zwischen globalen und lokalen Tone-Mapping Algorithmen unterschieden. Im Falle globaler Algorithmen wird für alle Pixel, unabhängig vom Ort, die gleiche Transformation durchgeführt. Diese Algorithmen sind sehr effizient und erlauben eine Echtzeitverarbeitung der Daten. Lokale Algorithmen agieren in lokalen Pixelnachbarschaften und versuchen beispielsweise in diesen Nachbarschaften den Kontrast bestmöglich zu erhalten. Sie sind rechenintensiver, liefern aber in der Regel kontrastreichere Bilder.

The Imaging Source hat die Notwendigkeit eines maximalen Dynamikumfangs im Machine-Vision Umfeld schon früh erkannt und bietet in seinen End-User Softwareprodukten und den Programmierschnittstellen die Möglichkeit an, sowohl HDR-Bilddaten zu akquirieren, als auch entsprechend durch Tone-Mapping zu visualisieren oder zu speichern. Viel Aufwand wurde dabei in die Benutzerfreundlichkeit der Algorithmen investiert. So gibt es für die Algorithmen entsprechende Automatikmodi, die sämtliche Parameter automatisch an die Szene adaptieren und kein Eingreifen des Benutzers erfordern. Das Ergebnis sind von Haus aus kontrastreiche Aufnahmen mit brillanten natürlichen Farben. Insbesondere die End-Eser Software IC Measure nutzt mittlerweile standardmäßig, sofern von der Kamera unterstützt, die HDR Funktionalitäten und präsentiert dem Nutzer HDR Bilder.

Der obige Artikel, verfasst von Dr. Oliver Fleischmann (Projektmanager bei The Imaging Source), wurde in der April 2018-Ausgabe der Zeitschrift inspect unter dem Titel, "High-Dynamic-Range Imaging in modernen Industriekamerasveröffentlicht."